En la actualidad, vivimos en un mundo donde la información es crucial y su uso puede tener un impacto significativo en miles de personas, por lo que es vital abordar el tema de la ética de los datos. Pero, ¿qué significa exactamente este término?

A rasgos generales, la ética se refiere al estudio de la conducta humana y lo que es considerado correcto o incorrecto. En el caso específico de la ética de los datos, se trata de un conjunto de normas que se enfocan en los problemas relacionados con el uso de datos, algoritmos y prácticas correspondientes. Aunque todavía es un campo relativamente nuevo, se están estableciendo normas éticas basadas en estándares comunes, lo que nos permite determinar si el uso de los datos es beneficioso o no en muchos casos.

La inteligencia artificial (IA) se basa en entrenar algoritmos con datos existentes para crear otros nuevos. Por ejemplo, puede utilizarse para identificar imágenes a través de fotografías o para enseñar a un robot a caminar y evitar obstáculos, utilizando datos de su entorno y capacidades de movimiento. En la práctica, la IA puede ser aplicada en una amplia variedad de tareas, como la identificación de patrones en grandes conjuntos de datos, la automatización de procesos industriales o el desarrollo de sistemas de asistencia al conductor en vehículos. Las técnicas de IA incluyen el aprendizaje automático, el procesamiento del lenguaje natural y la visión artificial, y pueden aplicarse en campos como la medicina, la ingeniería, la robótica y, por supuesto, el análisis de datos, entre otros.

Al tener múltiples aplicaciones, algunas puedes resultar buenas y otras malas. Por ejemplo, la IA puede tener mucho peso en los medios de comunicación y servir para informar. Algunos ejemplos de este tipo de IAs son BotSentinel, una herramienta de Twitter que detecta perfiles falsos, el algoritmo de Facebook, para detectar noticias engañosas o IA que sirve para detectar cuándo una imagen está retocada. Por otro lado, la IA también puede ser utilizada para desinformar, como lo hace la herramienta deepTweets, que genera tweets falsos escritos en el estilo de una persona determinada, o la aplicación Faceswap, que puede utilizarse para simular que alguien ha dicho algo que nunca dijo. En ocasiones, la IA es un reflejo de la parte oscura de la sociedad.

Si se realiza una búsqueda en las noticias sobre Big Data, Algoritmos o Inteligencia Artificial, aparecerán titulares que demuestran los diversos usos de estas herramientas, algunos de los cuales pueden ser cuestionables desde una perspectiva ética: – “Las tecnologías basadas en big data a veces empeoran la discriminación a causa de sesgos implícitos en los datos” – «Si está en la cocina, es una mujer: cómo los algoritmos refuerzan los prejuicios»

En estos contextos se están personificando las inteligencias artificiales y esto hace que la persona que no tiene conocimientos sobre la materia, se haga la idea de que la culpa es de las máquinas, y no de los humanos que las hemos entrenado (es decir, los datos que se han elegido para entrenar).

Cuando un lector o lectora se encuentre un titular de este estilo, es importante que se pare a pensar porqué una inteligencia artificial ha podido tener una respuesta poco ética. Muchas veces, es por cuestiones de sesgo en los datos: existe mucha representación de un tipo de cosa, y poca de otra.

Parece ser que el algoritmo del traductor de Google es machista. ¿Pero es así? Recordemos, que los algoritmos no podemos personificarlos, no tienen sentimientos, así que seguramente el problema está en los datos.

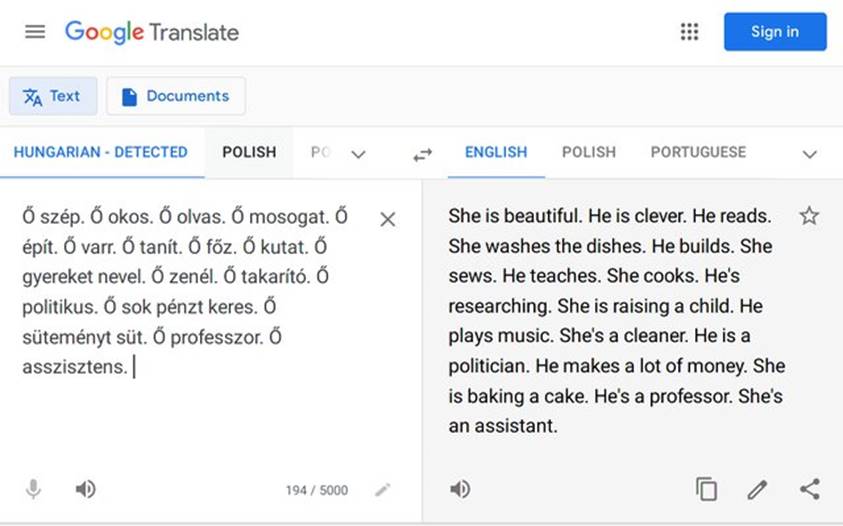

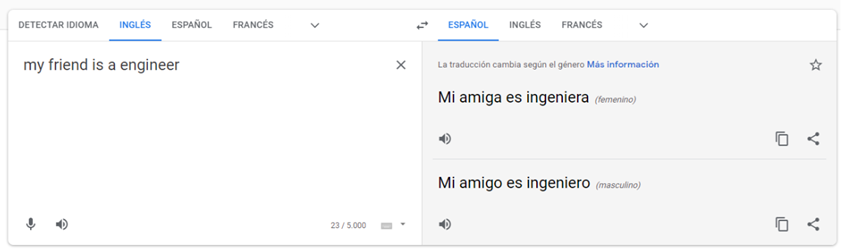

En este caso, si se traduce un texto de húngaro (sin género) a inglés, dependiendo del contexto, se traduce al masculino o al femenino. ¿Por qué puede estar ocurriendo esto? Por la representación de ambos géneros en los datos. Por ejemplo, por porcentaje: seguramente, la mayoría de políticos son hombres, por eso lo traduce al masculino, y la mayoría de las personas que se encargan de la crianza de un hijo son mujeres. Con los textos con los que Google se ha entrenado, era así la mayoría de veces, por lo que con la poca información que tiene en el momento de traducir, y con los datos que se han entrenado, el algoritmo ha aprendido que tiene más posibilidad de acertar la traducción utilizando un género determinado. Actualmente Google, sabiendo que esto estaba ocurriendo en muchos idiomas, si falta contexto como para saber el género, ofrece las dos opciones, como solución a este comportamiento poco ético que tenía inicialmente:

Como éstos, existen otros mil ejemplos. Hay que evitar tener miedo a los algoritmos, y lo que se tiene que hacer es, ya que se sabe que se han entrenado mal, hacer la reflexión de qué ha podido ocurrir.